다양한 벤치마크 및 평가 방법론이 개발되어 대규모 언어 모델(LLM)의 발전을 효과적으로 평가할 수 있게 되었습니다. AI 엔지니어들은 LLM의 성능을 정확히 측정하고 비교하기 위해 이러한 최신 벤치마크와 평가 지표들을 반드시 이해해야 합니다. 이 글에서는 2025년 현재 AI 업계에서 필수적으로 활용되는 벤치마크와 평가 방법을 살펴보겠습니다.

1. 주요 벤치마크 소개

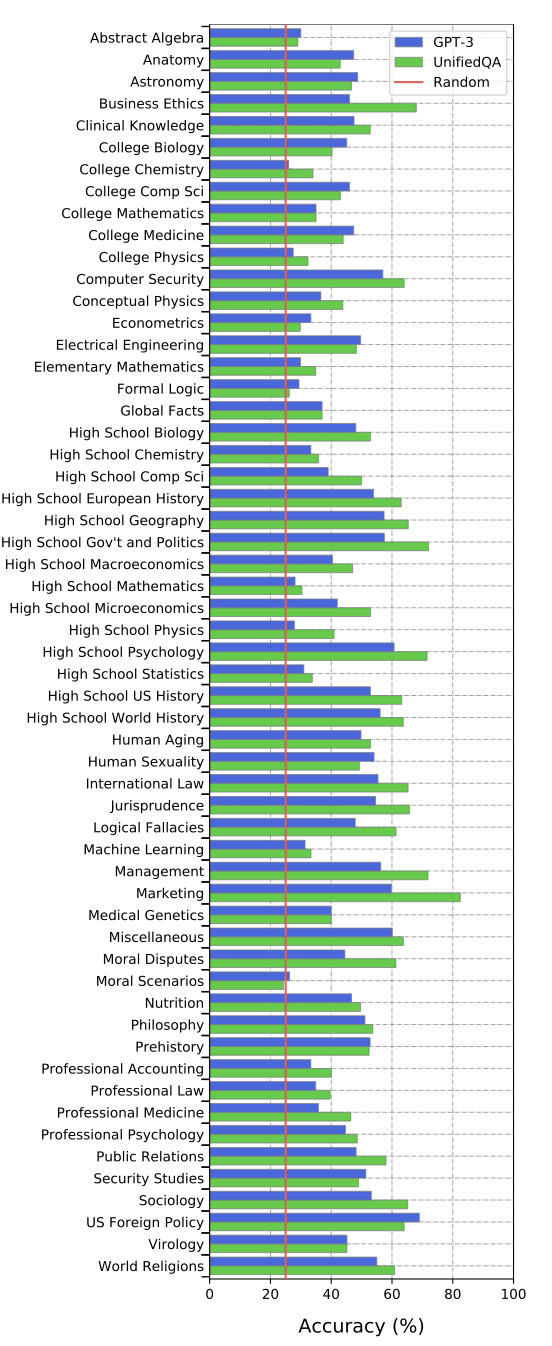

1.1 MMLU (Massive Multitask Language Understanding)

- MMLU 논문

- 주요 지식 평가 벤치마크로, 다음과 같은 고급 버전이 있습니다:

- LLM의 일반적 지식 및 이해도를 측정하는 데 널리 사용됩니다.

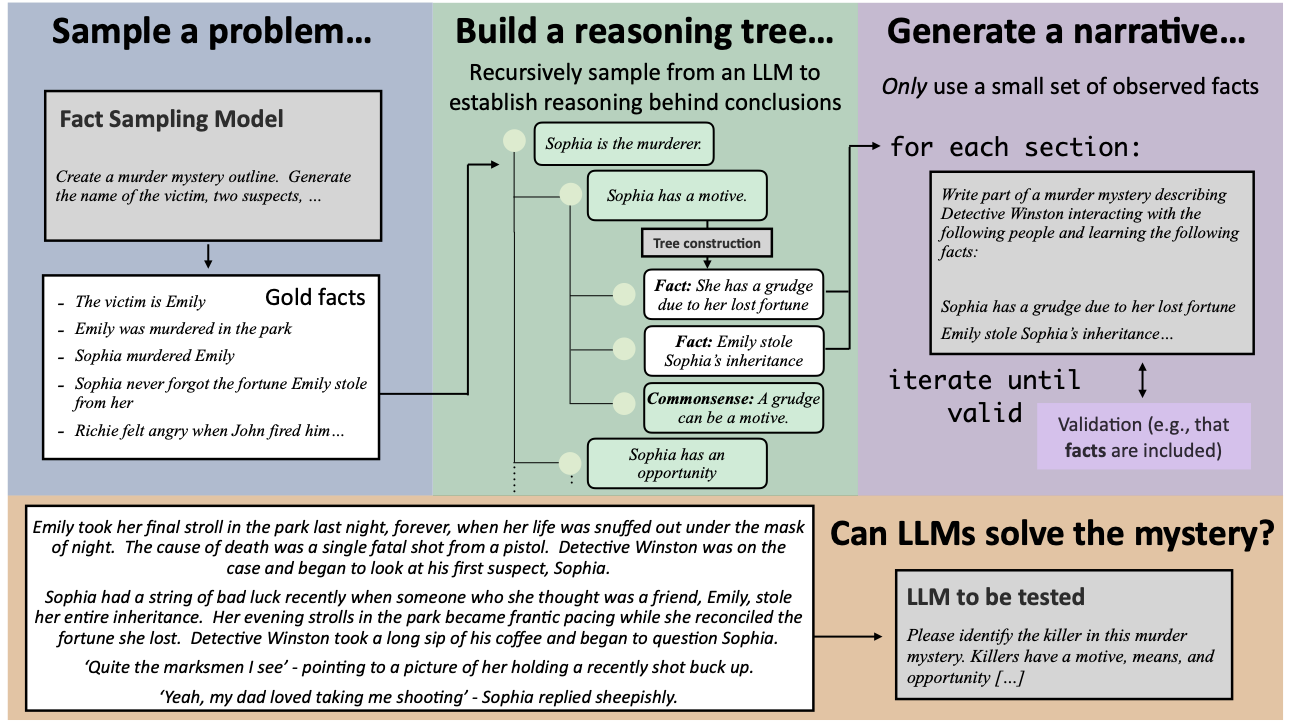

1.2 MuSR (Multi-Scale Representation)

- MuSR 논문

- 긴 문맥 처리를 평가하기 위한 벤치마크로 다음과 함께 활용됩니다:

- LLM이 대량의 정보를 효과적으로 유지하고 처리할 수 있는지를 평가합니다.

1.3 MATH 벤치마크

- MATH 논문

- 수학 경시대회 문제 풀이 능력을 평가하며, 아래와 같은 고급 평가 도구들이 있습니다:

- AI의 논리적 추론 및 수학적 능력을 측정하는 데 필수적입니다.

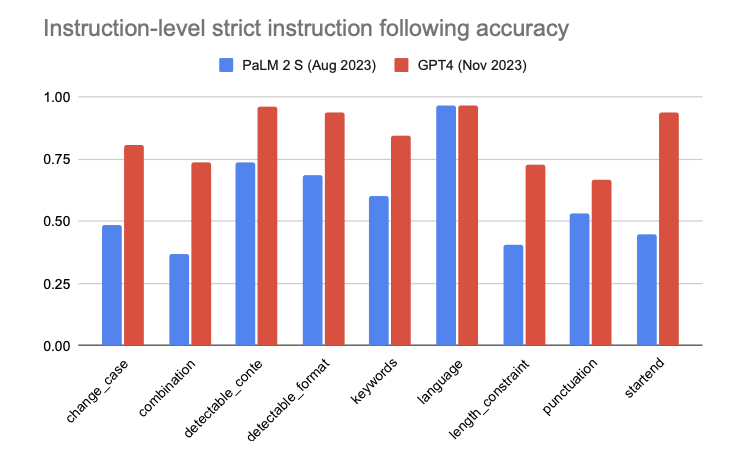

1.4 IFEval (Instruction Following Evaluation)

- IFEval 논문

- 주요 지시사항 따르기 평가 벤치마크로, Apple이 공식적으로 채택하였습니다.

- 유사 벤치마크: MT-Bench

- AI가 복잡한 지시사항을 얼마나 정확히 수행하는지 평가합니다.

1.5 ARC AGI 챌린지 (Abstraction and Reasoning Corpus for AGI)

- ARC 챌린지

- AI의 추상적 추론 및 문제 해결 능력을 측정하는 "IQ 테스트"형 벤치마크.

- LLM이 인간 수준의 창의적 사고를 수행할 수 있는지를 평가하는 데 중요합니다.

2. 벤치마크의 중요성

LLM 성능 평가에서 가장 중요한 것은 정확한 벤치마크를 통해 모델의 강점과 약점을 파악하는 것입니다. 최신 연구들은 모델의 다양한 능력을 평가하기 위해 여러 핵심 분야의 벤치마크를 제시하고 있습니다.

- 지식 평가: MMLU, GPQA, BIG-Bench

- 긴 문맥 처리: MuSR, LongBench

- 수학적 능력: MATH, FrontierMath

- 지시사항 수행: IFEval, MT-Bench

- 추상적 추론: ARC AGI

3. AI 엔지니어가 알아야 할 평가 전략

LLM의 성능을 정확하게 평가하기 위해서는 다음과 같은 핵심 전략들이 필요합니다.

- 다양한 벤치마크 활용: 하나의 벤치마크에만 의존하지 말고, 여러 벤치마크를 조합하여 모델의 종합적인 능력을 평가해야 합니다.

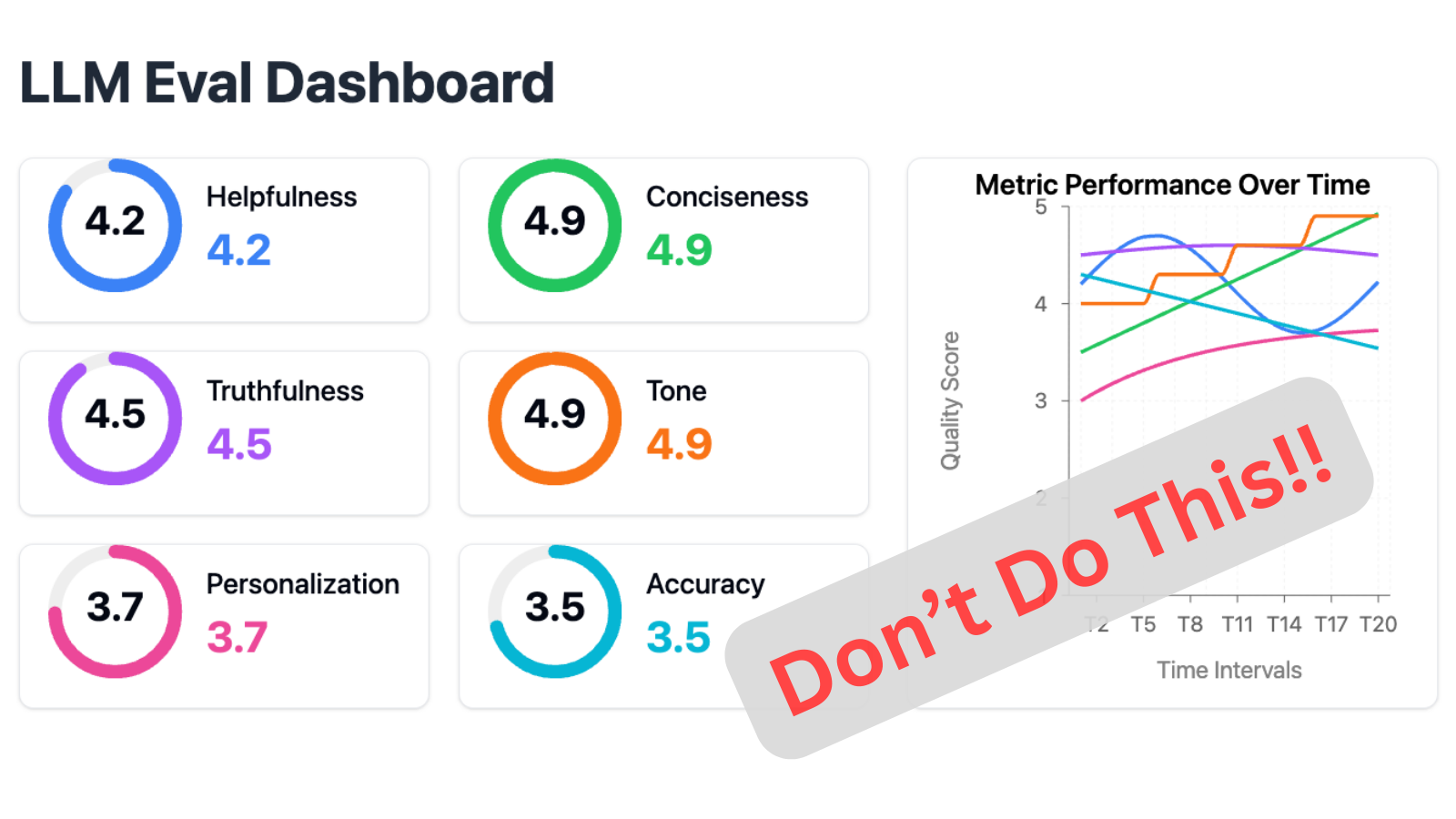

- 정량적 및 정성적 평가: 수치적 정확도와 함께 실제 사용자 피드백을 통한 질적 평가를 병행해야 합니다.

- LLM-as-Judge 활용: LLM-as-Judge 프레임워크로 AI 기반 자동 평가 시스템을 구축할 수 있습니다.

- 지속적 모니터링: 벤치마크 결과를 주기적으로 분석하고 새로운 평가 방식을 도입하여 지속적인 성능 개선을 도모해야 합니다.

4. 최신 벤치마크 트렌드를 따라잡는 방법

최신 벤치마크와 평가 동향을 효과적으로 파악하기 위해 AI 엔지니어가 활용해야 할 핵심 전략은 다음과 같습니다.

- 벤치마크 리포트와 연구 논문 정기 모니터링: ArXiv와 주요 AI 연구 기관의 발표 자료를 정기적으로 확인하여 최신 동향 파악.

- 벤치마크 실험과 실제 적용: Hugging Face의 오픈소스 LLM 모델을 활용한 직접적인 실험과 검증.

- 커뮤니티와 전문가 의견 수집: Reddit, Discord, Kaggle 등 전문가 커뮤니티의 평가 결과와 인사이트 공유.

맺음말

AI 모델의 성능을 정확하게 평가하는 것은 AI 엔지니어의 핵심 역량입니다. 벤치마크는 LLM의 강점과 약점을 파악하는 필수 도구로, 이를 통해 효과적인 모델 최적화와 개선이 가능합니다. 앞으로도 지속적인 연구와 벤치마크 개발을 통해 더욱 정교한 평가 방법이 등장할 것입니다.

LLM의 발전과 함께 평가 방법론도 진화하고 있습니다. 다양한 목적으로 개발된 LLM, sLLM 등의 모델들을 평가하는 최신 벤치마크 트렌드와 방법론을 꼭 살펴보시기 바랍니다.

2025년 AI 엔지니어가 꼭 읽어야할 정보를 더 확인하고 싶으시다면

⬇⬇아래 링크를 확인해주세요.

2025년 AI 엔지니어가 꼭 읽어야할 정보, 최신 LLM편

AI 엔지니어를 꿈꾸거나 현업에서 일하시는 분들은 분기마다 급속도로 발전하는 LLM의 진화 속도를 따라가기가 쉽지 않습니다. 인공지능(AI)은 지속적으로 발전하고 있으며, 특히 대규모 언어 모

baruninfo.co.kr

2025년 AI 엔지니어가 꼭 읽어야 할 정보, 프롬프팅편

인공지능(AI) 발전에 따라 프롬프팅(Prompting) 기술은 대규모 언어 모델(LLM)의 성능을 최적화하는 핵심 요소가 되었습니다. 프롬프팅은 AI 모델의 잠재력을 끌어내고 효과적인 결과를 얻기 위한 필

baruninfo.co.kr

AI 엔지니어가 꼭 읽어야 할 정보: Fine-Tuning편

AI 모델의 성능을 극대화하고 특정 도메인에 최적화하기 위해 파인튜닝(Fine-Tuning) 기술은 필수적입니다. 2025년에는 보다 효율적이고 비용 효과적인 파인튜닝 방법이 등장하고 있으며, AI 엔지니

baruninfo.co.kr

AI 엔지니어가 꼭 읽어야 할 정보: 이미지/비디오 디퓨전편

인공지능(AI) 기반의 이미지 및 비디오 디퓨전 기술은 콘텐츠 생성 및 편집에서 점점 더 중요한 역할을 하고 있습니다. AI 엔지니어들은 최신 디퓨전 모델, 벤치마크, 그리고 실무 적용 전략을 숙

baruninfo.co.kr

AI 엔지니어가 꼭 읽어야 할 정보, 음성(Voice)편

인공지능(AI) 음성 기술은 빠르게 발전하고 있으며, 음성 인식(ASR) 및 텍스트 음성 변환(TTS) 분야에서 혁신적인 연구들이 지속적으로 발표되고 있습니다. AI 엔지니어들은 최신 음성 모델, 벤치마

baruninfo.co.kr

AI 엔지니어가 꼭 읽어야 할 정보: Vision편

인공지능(AI)의 발전과 함께 컴퓨터 비전(Vision) 기술은 다양한 산업 분야에서 필수적인 요소로 자리 잡았습니다. 2025년을 맞이하여 AI 엔지니어들은 최신 비전 모델, 벤치마크 및 실무 적용 방안

baruninfo.co.kr

AI 엔지니어가 꼭 읽어야 할 정보, 코드 생성(Code Generation)편

인공지능(AI)을 활용한 코드 생성(Code Generation) 기술은 소프트웨어 개발의 자동화와 생산성을 극대화하는 핵심 분야로 자리 잡고 있습니다. 2025년을 맞이하여 AI 엔지니어들은 최신 코드 생성 모

baruninfo.co.kr

AI 엔지니어가 꼭 읽어야 할 정보, Agent편

AI 에이전트(Agent)는 2025년 인공지능(AI) 산업에서 가장 주목받는 기술 중 하나로, 자율적인 문제 해결과 복잡한 작업 자동화를 가능하게 합니다. AI 엔지니어들은 최신 에이전트 기술과 벤치마크

baruninfo.co.kr

AI 엔지니어가 꼭 읽어야할 정보, RAG편

인공지능(AI) 기술이 발전함에 따라 검색 증강 생성(RAG, Retrieval-Augmented Generation)은 대규모 언어 모델(LLM)의 핵심 기능으로 자리 잡았습니다. RAG는 외부 정보를 검색하고 이를 모델의 출력에 통합

baruninfo.co.kr