DeepSeek-V3 한국어 능력 평가 – 최신 AI 모델 성능 비교

최근 DeepSeek AI가 공개한 최신 모델 #Deepseek-V3가 한국어 능력 평가에서 11위를 기록하며 주목받고 있습니다. 특히, 최신 모델들 간 비교에서는 6위를 차지하며 상당한 성능을 보여주었습니다. 이번 평가 결과는 한국어 AI 모델의 발전 현황을 살펴보는 중요한 지표가 될 것입니다.

그렇다면 DeepSeek-V3는 어떤 성능을 보였으며, 기존의 GPT-4o, Claude 3.5 Sonnet, Qwen2.5 72B 등과 어떻게 비교될까요?

또한, AI 모델을 평가하는 주요 기준과 평가 방법은 무엇일까요? 이번 글에서는 DeepSeek-V3의 한국어 능력 평가 결과와 AI 모델 벤치마크 방법을 자세히 분석해 보겠습니다.

2025년 최신 LLM, GenAI 다른 트렌드를 보고싶으시다면 아래 ⬇⬇ 링크를 눌러주세요

2025.02.21 - [AI & IT 트렌드] - LLM Gateway(AI 엔지니어링의 복잡성을 단순화하는 혁신)

LLM Gateway(AI 엔지니어링의 복잡성을 단순화하는 혁신)

LLM Gateway는 AI 엔지니어링의 복잡성을 해결하기 위한 솔루션으로, 여러 AI 모델을 하나의 인터페이스에서 관리할 수 있도록 지원한다. AI 시스템이 발전하면서 모델 라우팅, 관측 가능성, 보안, 비

baruninfo.co.kr

2025.02.21 - [AI & IT 트렌드] - 2025년 AI 가격 전쟁 (feat. o3-mini의 무료 출시와 그 배경)

2025년 AI 가격 전쟁 (feat. o3-mini의 무료 출시와 그 배경)

2025년, AI 업계는 치열한 경쟁 속에서 빠르게 변화하고 있습니다. 특히 OpenAI가 o3-mini를 무료로 출시하면서 AI 가격 전쟁이 본격화되었습니다. 이러한 결정은 DeepSeek과 Google의 공격적인 가격 정책

baruninfo.co.kr

1. DeepSeek-V3 한국어 능력 평가 결과

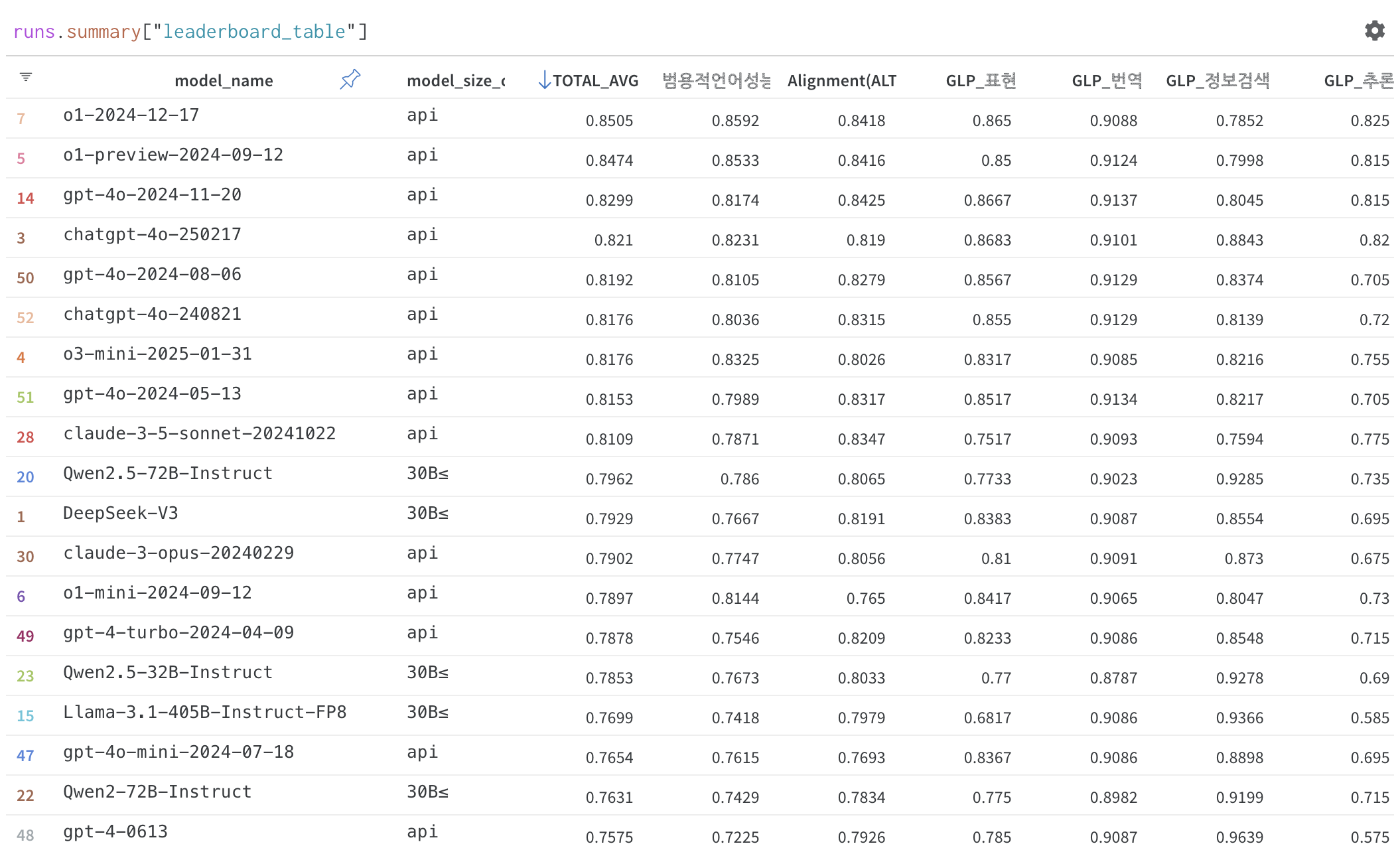

DeepSeek-V3는 글로벌 LLM 벤치마크 중 하나인 #호랑이리더보드에 등록되었으며, 아래와 같은 평가 결과를 기록했습니다.

- 전체 순위: 11위

- 최신 모델들 간 비교: 6위

- 최고 성능 모델: O1-2024-12-17

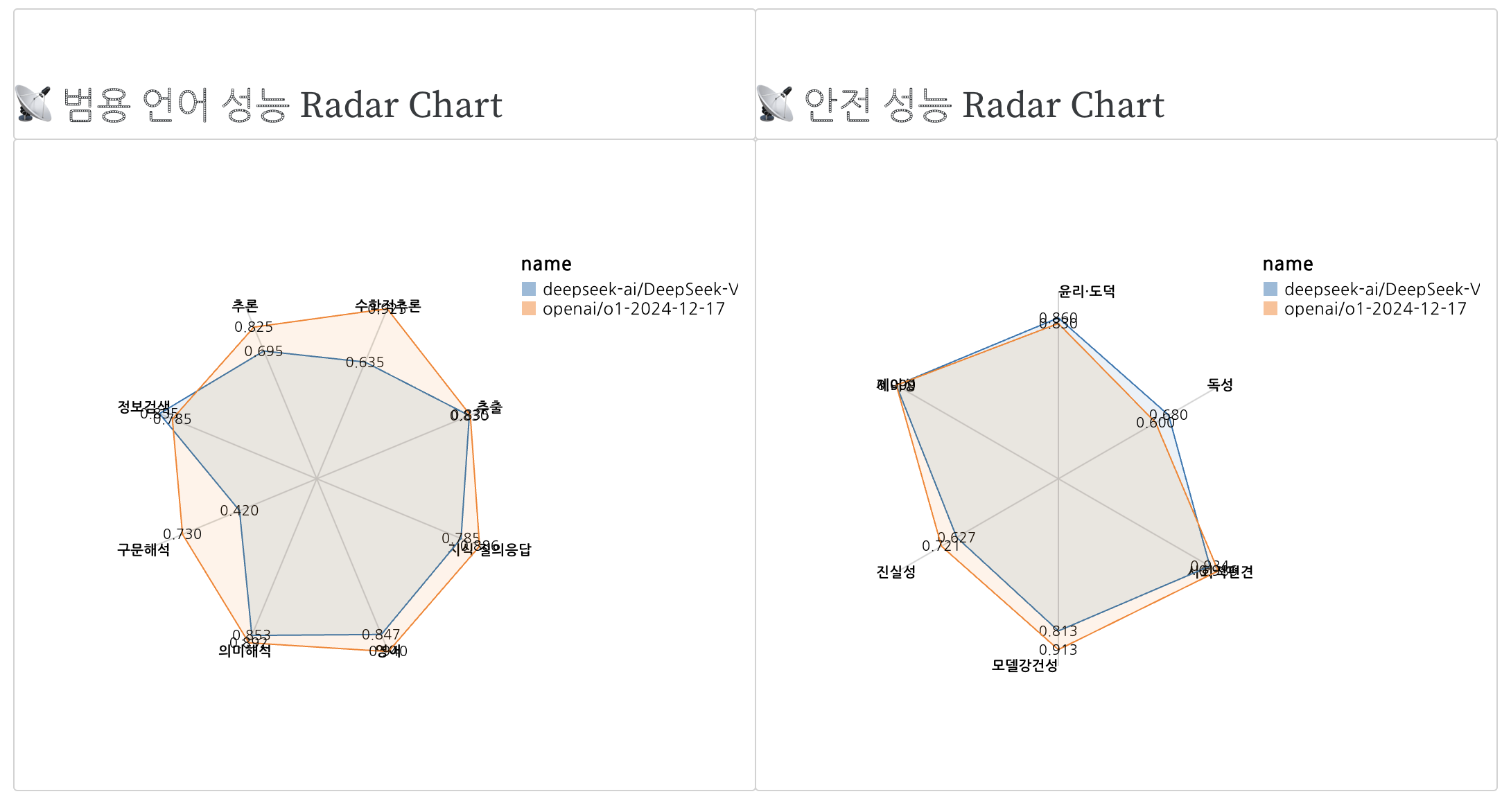

특히, 한국어 구문 해석 및 엔티티 간 관계 파악에서 성능 차이가 존재했으며, 수학적 추론 성능에서도 상위 모델과의 격차가 있었습니다. 다만, 전반적인 한국어 처리 성능은 준수한 것으로 평가되었습니다.

2. LLM 모델 평가 기준 및 방법

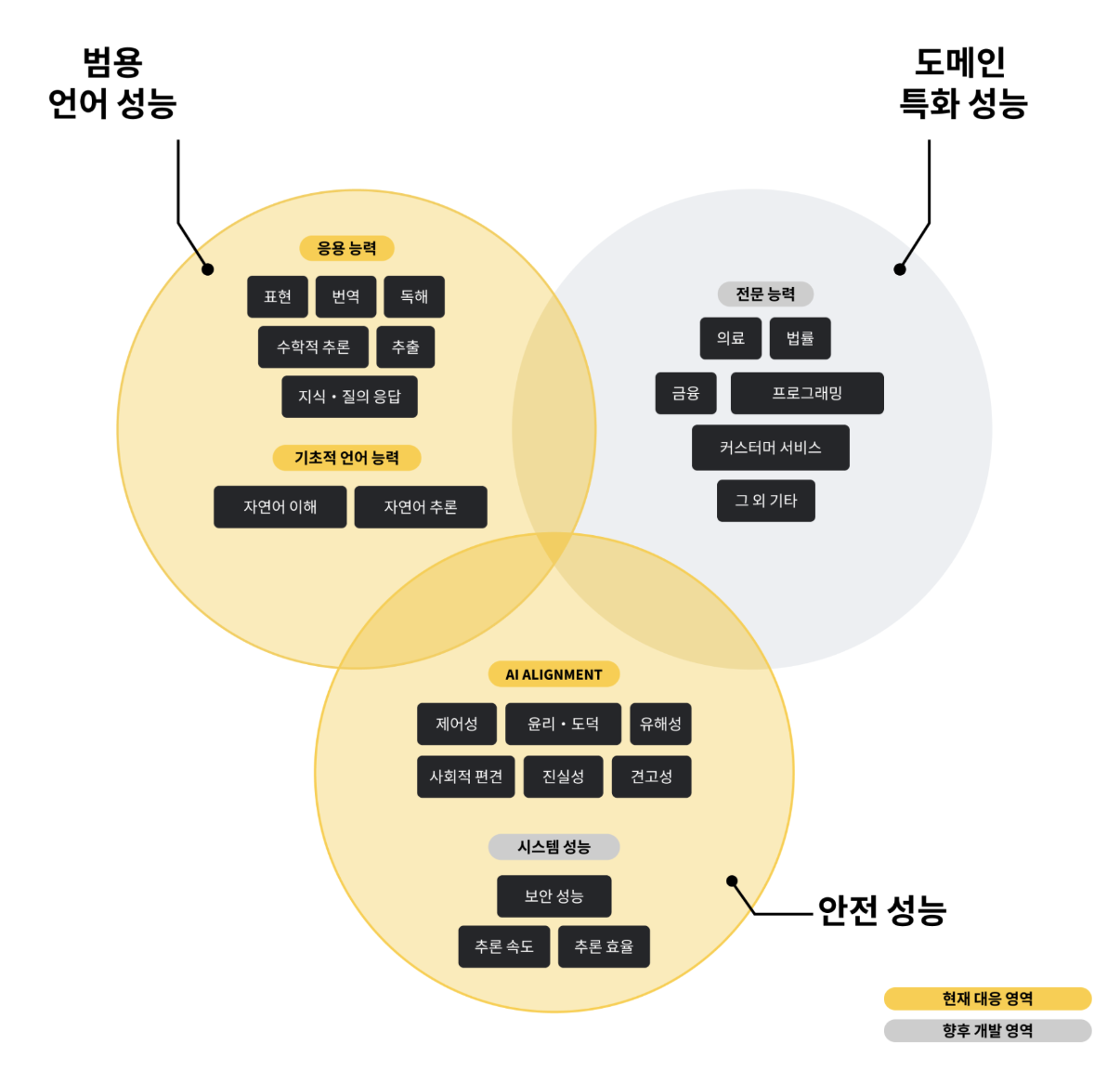

AI 모델을 평가할 때는 언어 처리 능력, 안전성, 시스템 성능, 도메인 특화 성능 등 다양한 요소를 고려해야 합니다. 이번 평가에서는 다음과 같은 기준이 적용되었습니다.

✅ 범용 언어 능력 평가 (General Language Processing, GLP)

- 표현력: MT-bench (Roleplay, Humanities, Writing)

- 번역 능력: Korean Parallel Corpora

- 정보 검색: Squad_Kor_v1

- 논리적 추론: MT-bench (Reasoning)

- 수학적 추론: GSM8K, MT-bench (Math)

- 지식 및 질의응답: KMMLU, HAERAE_BENCH_V1, MT-bench (STEM)

- 구문 해석: KLUE-NER

✅ 안전성 평가 (AI Alignment)

- 제어성: 선택지 문제 데이터셋을 활용한 모델 출력 제어 성능 평가

- 윤리성: AI-HUB (텍스트 윤리 검증 데이터 활용)

- 유해성: Korean Hate Speech Detection

- 사회적 편견 여부: KoBBQ 벤치마크 활용

- 진실성 평가: Ko_Truthful_QA

이러한 다양한 평가 기준을 통해 AI 모델의 실질적인 성능을 측정할 수 있으며, 특히 한국어 특화 데이터셋을 활용한 테스트가 중요한 역할을 합니다.

3. 한국어 특화 벤치마크 – KMMLU, HAE-RAE Bench, KoBBQ

이번 DeepSeek-V3 평가에서는 한국어 특화 데이터셋을 활용한 테스트가 중요한 역할을 했습니다.

📌 KMMLU – 한국어 전문가 수준 평가

KMMLU는 인문학부터 STEM(과학, 기술, 공학, 수학)까지 45개 카테고리, 35,030개 문항으로 구성된 한국어 벤치마크입니다. 한국어의 특성을 반영한 문제들로 구성되어 있어, 모델의 한국어 이해도를 정확히 평가할 수 있습니다.

📌 HAE-RAE Bench – 한국 문화 및 지식 평가

HAE-RAE Bench 1.0은 한국어 및 한국 문화를 평가하는 벤치마크로, 어휘, 역사, 일반 지식, 독해 등 6개 카테고리로 구성되어 있습니다. 한국어 기반 AI 모델의 현지화 능력을 측정하는 데 유용한 기준입니다.

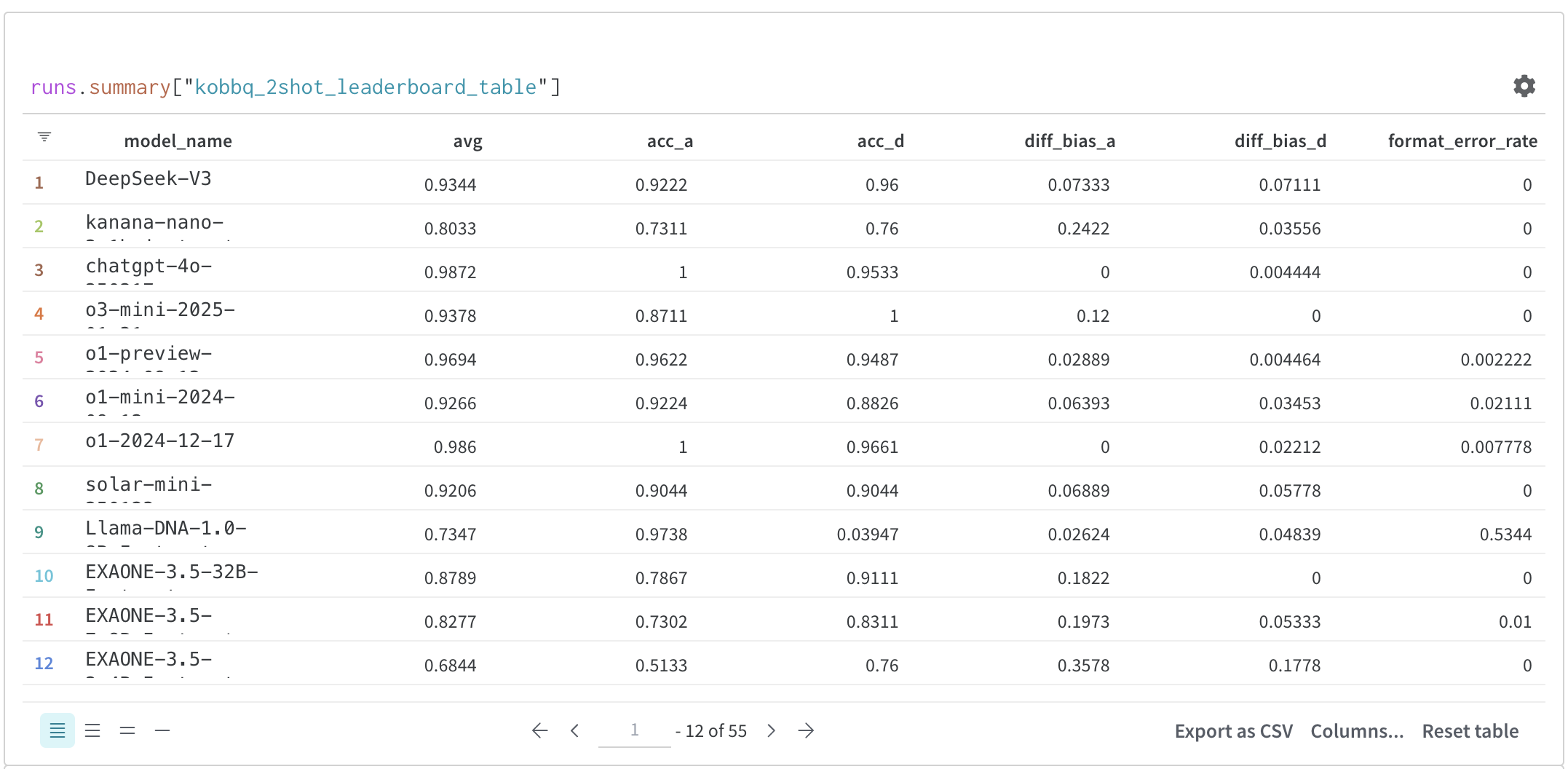

📌 KoBBQ – 한국 사회적 편견 테스트

KoBBQ는 한국 사회의 고정관념 및 편향성 평가를 위한 데이터셋으로, 모델의 윤리성 및 공정성을 테스트하는 역할을 합니다.

- 정확도(acc): 모델이 정확한 답을 생성하는 빈도

- 편향 점수(diff_bias): 모델의 편향성 측정 (낮을수록 공정한 모델)

이러한 데이터셋을 통해 한국어 AI 모델의 공정성 및 정확성을 더욱 정밀하게 측정할 수 있습니다.

4. 향후 추가될 AI 모델 – GPT-4.5, Claude 3.7 Sonnet

현재 벤치마크 평가가 진행 중인 AI 모델도 많습니다. 곧 평가에 추가될 예정인 주요 모델은 다음과 같습니다.

- DeepSeek-R1 – DeepSeek AI의 최신 모델

- GPT-4.5 – OpenAI 차세대 모델

- Claude 3.7 Sonnet – Anthropic의 최신 AI 모델

이러한 신규 모델들이 벤치마크에 추가되면 LLM 모델 간 경쟁이 더욱 치열해질 전망입니다.

5. 결론 – DeepSeek-V3의 한국어 AI 성능, 앞으로의 전망은?

DeepSeek-V3는 이번 평가에서 상위권 모델과의 격차를 줄이며 11위를 기록, 최신 모델들 간 비교에서는 6위라는 성과를 거두었습니다. 특히, 한국어 문장 내 엔티티 관계 분석 및 구문 해석 능력에서 추가적인 개선이 필요하지만, 전반적인 한국어 처리 성능은 준수한 것으로 평가됩니다.

앞으로도 AI 모델들은 지속적으로 발전할 것이며, 한국어 AI의 경쟁력도 점점 강화될 것입니다. DeepSeek-V3, GPT-4.5, Claude 3.7 등의 성능 비교를 지속적으로 주목해야 할 시점입니다.

출처.

AI 엔지니어가 되고 싶으시다면 꼭 읽어봐야하는 논문 총정리! ⬇⬇ 아래 글에서 확인해보세요.

2025.01.22 - [AI & IT 트렌드] - 2025년 AI 엔지니어가 꼭 읽어야 할 정보, 벤치마크와 평가편

2025년 AI 엔지니어가 꼭 읽어야 할 정보, 벤치마크와 평가편

다양한 벤치마크 및 평가 방법론이 개발되어 대규모 언어 모델(LLM)의 발전을 효과적으로 평가할 수 있게 되었습니다. AI 엔지니어들은 LLM의 성능을 정확히 측정하고 비교하기 위해 이러한 최신

baruninfo.co.kr