어텐션이란? 🤔

어텐션(Attention)은 중요한 부분에 집중하는 기술입니다. 문장 내에서 각 단어 간의 관계를 분석하여 가장 의미 있는 정보를 강조하는 역할을 합니다. 예를 들어,

"나는 어제 친구와 영화를 봤다."

이 문장에서 "영화"라는 단어를 올바르게 이해하려면 "봤다"와의 관계가 중요합니다. 어텐션은 이런 관련성을 계산해 자연어 처리 모델이 핵심 정보를 더욱 잘 이해하도록 돕는 기술입니다.

Transformer에서 어텐션의 작동 원리 🛠️

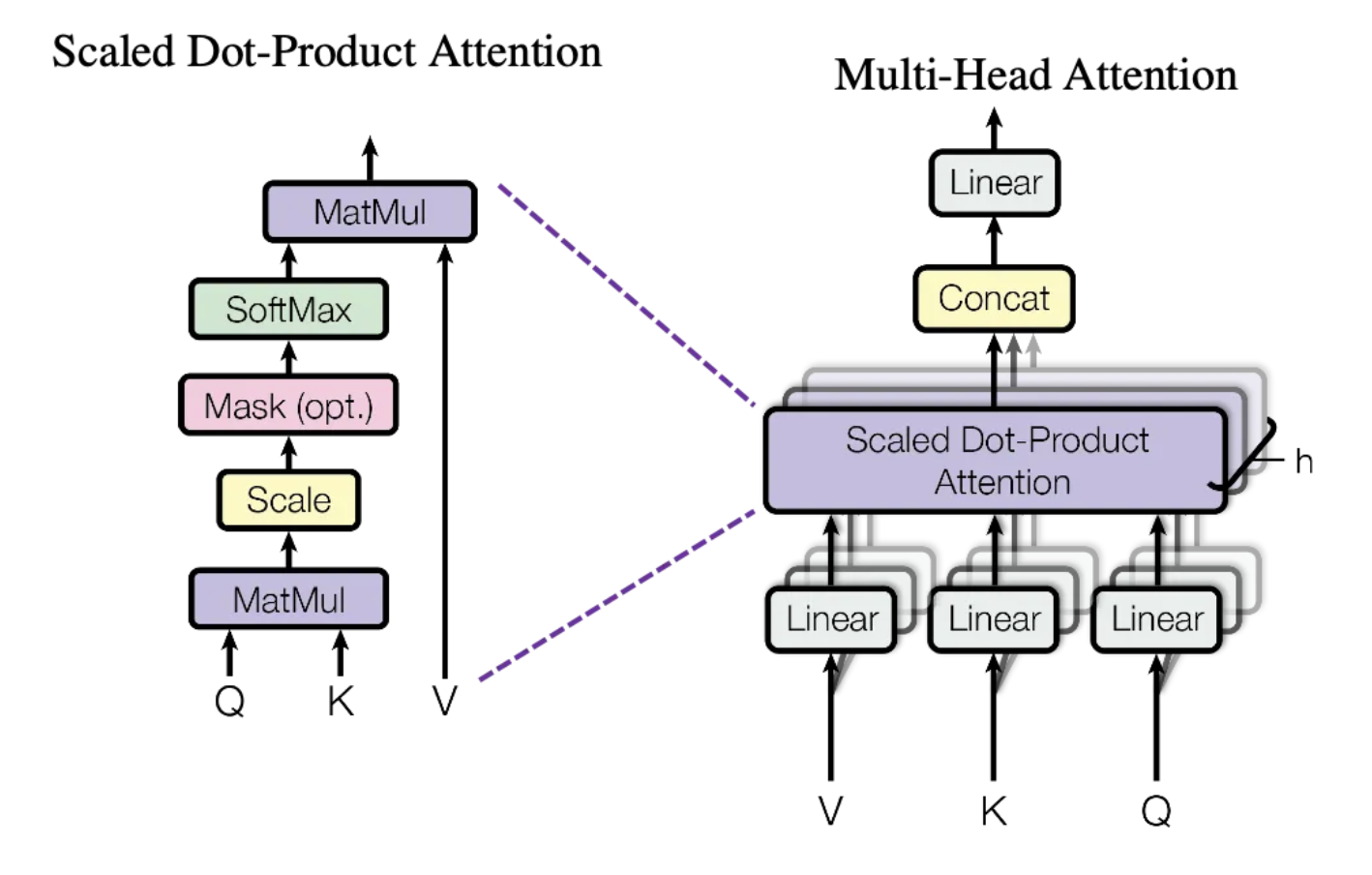

Transformer 모델의 어텐션 메커니즘은 Query(Q), Key(K), Value(V) 세 가지 요소를 중심으로 작동합니다.

- Query (Q): 찾고 싶은 정보 (ex. "영화"와 관련된 단어 찾기)

- Key (K): 각 단어의 특징 정보 (ex. 문장 내 모든 단어의 의미)

- Value (V): 단어가 포함하고 있는 실제 정보

💡 어텐션 작동 방식

- Query와 Key를 비교해 각 단어 간의 중요도를 계산합니다.

- 중요도가 높은 단어의 Value를 더 많이 반영하여 최종 결과를 생성합니다.

즉, Transformer 모델은 입력 문장 내 모든 단어가 서로 어떤 관계를 가지는지 계산한 후, 가장 중요한 정보에 더 집중할 수 있도록 설계되었습니다.

Transformer에서 사용되는 주요 어텐션 종류 🔍

1. 셀프 어텐션(Self-Attention)

✅ 문장 내 모든 단어 간의 관계를 계산하는 방식입니다.

📌 예시

- "나는 사과를 먹었다"라는 문장에서 "사과"는 "먹었다"와 가장 관련이 깊음

🛠️ 특징

- 문장 전체를 동시에 고려해 더 깊이 있는 의미를 학습

- 병렬 처리가 가능하여 연산 속도가 빠름

2. 크로스 어텐션(Cross-Attention)

✅ 디코더가 인코더에서 얻은 정보를 참고할 때 사용됩니다.

📌 예시

- 영어 문장을 한국어로 번역할 때 디코더가 인코더에서 받은 정보를 이용하여 문장을 생성함

🛠️ 특징

- 입력(인코더)과 출력(디코더) 간의 관계를 분석

- 번역, 요약 등의 작업에서 필수적인 역할 수행

3. 마스크드 어텐션(Masked Attention)

✅ 디코더에서 미래 단어를 보지 못하도록 제한하는 어텐션입니다.

📌 예시

- "나는" 다음에 나올 단어를 예측할 때 아직 나오지 않은 단어는 숨김

🛠️ 특징

- 자연스러운 순서대로 텍스트를 생성 가능

4. 멀티 헤드 어텐션(Multi-Head Attention) 🎯

멀티 헤드 어텐션은 Transformer 모델에서 가장 강력한 기능 중 하나입니다.

멀티 헤드 어텐션이란?

- 한 번의 어텐션이 아니라, 여러 개의 어텐션을 병렬로 수행하여 다양한 관점에서 정보를 추출하는 방식

멀티 헤드 어텐션의 장점

✅ 다양한 시각 제공

- 한 어텐션 헤드는 명사 관계, 다른 헤드는 동사 관계 등 여러 패턴을 학습

✅ 복잡한 관계 학습

- 다양한 어텐션이 동시에 작동하여 더 깊이 있는 문맥 이해 가능

✅ 병렬 처리 가능

- 여러 헤드를 동시에 계산하므로 연산 속도가 빨라짐

💡 구조적인 특징

- 각 헤드는 독립적으로 Query, Key, Value를 계산하고 최종적으로 결합하여 더 정교한 결과를 생성

어텐션의 실제 활용 사례 📌

Transformer 모델의 어텐션 메커니즘은 다양한 자연어 처리(NLP) 작업에서 활용됩니다.

✅ 번역 (Machine Translation): 문장 간의 관계를 분석하여 더 정확한 번역 가능 (ex. 구글 번역)

✅ 텍스트 요약 (Summarization): 문서 내 핵심 정보를 추출하는 데 활용 (ex. 뉴스 요약)

✅ 챗봇 (Chatbot & AI Assistant): 대화 맥락을 이해하여 자연스러운 응답 생성

✅ 음성 인식 (Speech Recognition): 단어 간의 의미적 연관성을 학습하여 인식 성능 향상

결론: 어텐션이 Transformer의 핵심이다! 🚀

Transformer 모델에서 어텐션(Attention)은 중요한 정보를 강조하는 강력한 기술입니다. 특히 셀프 어텐션, 크로스 어텐션, 마스크드 어텐션과 같은 다양한 어텐션 메커니즘이 적용되며, 이를 더욱 발전시킨 멀티 헤드 어텐션이 모델의 성능을 극대화합니다.

👉 어텐션을 통해 Transformer는 자연어 처리, 번역, 요약, AI 챗봇 등 다양한 분야에서 놀라운 성과를 거두고 있습니다!

🔗 참고 자료

[1] 셀프 어텐션, 멀티 헤드 어텐션, 포지셔널 임베딩 등 - velog

[2] 어텐션 매커니즘(Attention Mechanism) - Hello, didi universe - 티스토리

[3] 트랜스포머(Transformer) 파헤치기—2. Multi-Head Attention

[4] Transformer 설명 - taeeyeong - 티스토리

[5] NLP 트랜스포머 다섯 번째, 여러 종류의 멀티헤드 어텐션과 피드포워드 네트워크

어텐션 개념이 궁금하셨다면, 이번 글이 도움이 되셨길 바랍니다! 😊