반응형

인공지능(AI) 기반의 이미지 및 비디오 디퓨전 기술은 콘텐츠 생성 및 편집에서 점점 더 중요한 역할을 하고 있습니다. AI 엔지니어들은 최신 디퓨전 모델, 벤치마크, 그리고 실무 적용 전략을 숙지하여 빠르게 발전하는 이 분야를 선도할 수 있어야 합니다. 본 글에서는 2025년 기준으로 이미지 및 비디오 디퓨전 기술의 최신 동향을 소개합니다.

1. 주요 이미지/비디오 디퓨전 모델 및 연구 동향

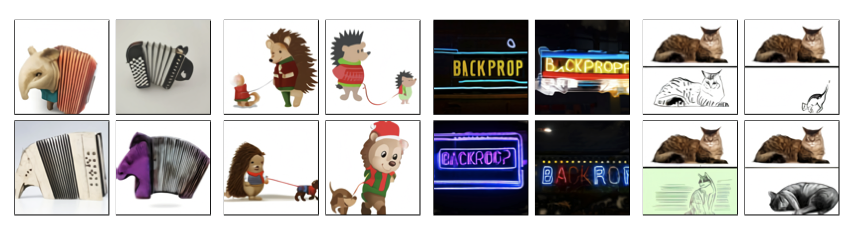

1.1 Stable Diffusion 및 Latent Diffusion

- Latent Diffusion 논문: Stable Diffusion의 핵심 논문으로, 텍스트 기반 이미지 생성을 위한 기본적인 원리 설명.

- 관련 연구:

- 최근 연구: BFL Flux 프로젝트.

1.2 DALL-E 시리즈

- OpenAI의 이미지 생성 모델:

1.3 Google의 Imagen 시리즈

- 최신 Imagen 모델:

- 참고: Ideogram 2.0

1.4 Consistency Models 및 LCM

- Consistency Models 논문

- LCM 논문 - 최신 버전: sCM

1.5 Sora 및 텍스트-비디오 생성

- Sora 블로그 포스트: 텍스트에서 비디오 생성의 혁신적인 사례.

- 참고 논문: DiT 논문

- 오픈소스 경쟁 모델: OpenSora

- 최신 분석: Lilian Weng의 조사

2. 실무 적용 전략

AI 엔지니어들이 이미지 및 비디오 디퓨전 기술을 실무에 적용하기 위해 고려해야 할 요소는 다음과 같습니다.

- 최신 모델 적용: Stable Diffusion, DALL-E, Imagen 등의 모델을 실제 프로젝트에 도입.

- 고급 프롬프트 엔지니어링: 텍스트 기반 이미지 생성의 정확도를 높이기 위한 기술 습득.

- 멀티모달 통합: 텍스트-이미지-비디오 통합 솔루션 구축.

- ComfyUI 활용: 시각적 워크플로우 최적화를 위한 ComfyUI 학습.

3. AI 이미지/비디오 디퓨전 트렌드를 따라잡는 방법

- 최신 논문 및 연구 자료 모니터링: ArXiv, Hugging Face, OpenAI 블로그.

- 오픈소스 프로젝트 실습: GitHub의 최신 모델 다운로드 및 실험.

- AI 컨퍼런스 및 웨비나 참여: NeurIPS, ICCV, CVPR 등.

마무리

이미지 및 비디오 디퓨전 기술은 지속적으로 발전하고 있으며, AI 기반 콘텐츠 생성의 새로운 가능성을 열어가고 있습니다. 최신 연구와 실무 적용 전략을 꾸준히 학습하여 미래의 AI 비전을 준비할 수 있습니다.

반응형