RNN(Recurrent Neural Networks)은 자연어 처리(NLP)의 기본 아키텍처로 오랫동안 활용되어 왔습니다. 하지만 트랜스포머(Transformer)의 등장으로 언어 모델의 패러다임이 완전히 바뀌었습니다. 이러한 혁신은 모델의 성능 향상, 효율성, 그리고 확장 가능성 측면에서 획기적인 전환점이 되었습니다. 이제 이러한 발전 과정과 변화의 배경을 살펴보겠습니다.

머신러닝, 딥러닝에 주로 사용된 RNN

RNN은 시퀀스 데이터(Sequential Data)를 처리하기 위해 설계된 네트워크로, 입력 데이터의 순서를 고려하며 학습할 수 있는 특성을 가지고 있습니다.

딥러닝이나 머신러닝 분야에서는 텍스트, 오디오, 시계열과 같은 데이터를 시계열 데이터라고 불렀습니다. 트랜스포머가 개발되기 전까지는 RNN을 활용해 텍스트를 생성했습니다.

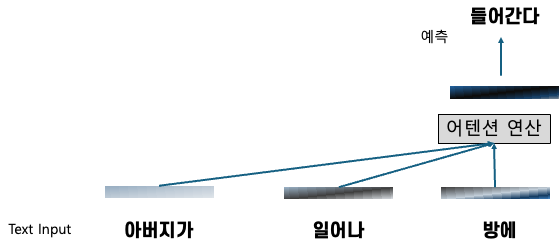

아래 그림과 같이 텍스트를 순차적으로 처리하여 다음 단어를 예측하는 방식이 일반적이었습니다.

RNN의 핵심은 모델이 하나의 Hidden State에 입력된 텍스트의 모든 맥락을 압축한다는 것입니다. 즉, 정보가 순차적으로 누적되면서 텍스트의 맥락이 하나의 상태로 압축됩니다. 이 방식은 여러 단어로 구성된 맥락을 하나의 State로 압축하므로 메모리 사용이 효율적입니다. 또한 다음 단어 예측 시 현재의 State와 입력 단어만으로 처리할 수 있어 생성 속도가 빠르다는 장점이 있습니다.

하지만 순차적으로 입력되는 단어들을 하나의 Hidden State에 압축하다 보니 먼저 입력된 단어의 의미가 점차 희석되며, 입력이 길어질수록 문맥을 충분히 담지 못해 성능이 저하되는 문제가 있습니다.

쉽게 말해, "긴 문맥"의 텍스트에서는 Vanishing Gradient 문제로 인해 문맥의 의미를 제대로 유지하지 못하는 치명적인 단점이 있습니다. 또한 RNN은 순차적 처리 방식으로 인해 병렬처리가 불가능하고, 입력 텍스트가 길수록 학습과 추론 속도가 현저히 저하됩니다. 이는 대용량 텍스트 데이터를 학습할 때 데이터양에 비례해 처리 시간이 계속 늘어날 수밖에 없는 구조적 한계를 의미합니다.

결과적으로 RNN은 작은 데이터셋에서는 우수한 성능을 보이지만, 대규모 데이터셋 학습에는 매우 비효율적인 모델이었습니다.

RNN의 장점

- 사람이 생각하는 방식 그대로 순차적으로 데이터를 학습해 “직관적인 이해” 가능

- Hidden State의 압축 방식으로 데이터를 적은 메모리로 관리 가능

- 압축된 데이터를 활용해 예측 생성하는 방식으로 빠른 단어 생성 가능

RNN의 단점

- 긴 문맥의 학습 어려움

- 순차적 처리로 인한 비효율성

- 학습 모델 용량의 제한

RNN의 성능을 개선하기 위한 LSTM과 GRU

RNN의 단점을 개선하기 위해 LSTM과 GRU가 등장했습니다. 이 아키텍처들은 게이트 구조를 도입해 긴 문맥 정보를 더 잘 유지하고, 기울기 소실 문제를 완화했습니다.

하지만 LSTM과 GRU도 RNN과 마찬가지로 순차적으로 데이터를 처리해야 하므로 병렬화하기 어렵다는 RNN의 단점을 극복하지 못했습니다. 또한 여전히 대규모 데이터셋, 긴 문맥의 텍스트를 완벽히 학습하지 못하다는 문제는 여전히 남아 있었습니다.

LSTM과 GRU가 등장했을 때만해도 시계열 데이터의 예측성능에 모두 환호했지만 RNN의 고질적인 대규모 데이터 학습에 부적합하다는 사실이 등장이후 1년간 꾸준히 관련 논문에서 언급되었습니다.

트랜스포머(Transformer)의 등장 (feat. 어텐션)

이때 2017년 등장한 트랜스포머 아키텍처(논문 *Attention Is All You Need)*는 RNN의 순차적인 처리 방식을 버리고, 입력되는 텍스트의 맥락을 모두 참조하는 “어텐션(Attention) 연산”을 사용해 RNN의 문제를 대부분 해결 했습니다.

RNN이 하나의 Hidden State로 맥락을 압축했던 것과 달리 매갉 데이터를 그대로 모두 활용해 다음 단어를 예측하는 방식으로 매커니즘을 바꾼것입니다. 이를 좀더 쉽게 설명하면 “들어간다”를 예측할 때 이전의 맥락인 ‘아버지가’, ‘일어나’, ‘방에’의 관계를 모두 계산한다는 것입니다.

트랜스포머 아키텍처는 맥락을 압축하지 않고 그대로 활용하기 때문에 성능을 높일 수 있지만, 텍스트를 모두 저장하고 있어야 하기 때문에 메모리 사용량이 증가합니다. 또한 매번 다음 단어를 예측할 때마다 맥락 데이터를 모두 확인해야 하기 때문에 텍스트 입력이 길어지면 예측에 걸리는 시간도 증가합니다.

이처럼 트랜스포머 아키텍처는 많은 연산량이 필요하다는 단점을 가지고 있지만 성능이 좋고 순차적으로 처리하는 RNN과 달리 병렬 처리를 통해 학습 속도를 높일 수 있어 “연산량이 많다”는 단점은 병렬처리로 보완하며 대부분의 LLM이 트랜스포머 아키텍처를 기반으로 하고 있습니다.

딥러닝을 공부한 모두가 들어본 BERT, LLM을 선도하는 GPT도 모두 트랜스포머 아키텍처를 기반으로 학습한 모델인 것입니다.

트랜스포머 그 이후는?

그렇다면 트랜스포머 아키텍처가 기술의 임계점일까요? 그렇지 않을겁니다.

RNN이 대규모 데이터셋을 학습하지 못한다는 단점, 성능을 끌어낼수 없는 문제를 트랜스포머가 해결했지만, 트랜스포머 아키텍처를 제대로 활용하기 위해선 학습하는 데이터셋에 걸맞는 엄청난 학습 인프라가 필요하다는 단점이 존재합니다.

트랜스포머는 성능은 좋지만 비효율적이고, RNN은 효율적이지만 성능이 낮아 각각 성능 우선, 효율성 우선에 방점을 찍고 있는데요. 점선과 같은 “새로운 아키텍처” 처럼 성능과 효율성을 모두 가지는 아키텍처를 찾기 위한 연구가 꾸준히 진행중이지만 대부분 트랜스포머의 성능에 미치지 못했기에 크게 주목을 못받고 있었습니다.

그러던 중에 2023년 12월 “Mamba”가 공개되고 효율성과 성능 두마리 토끼를 모두 갖춘 새로운 아키텍처가 공개되어 많은 연구자들의 기대를 받고 있습니다.

“Mamba 아키텍처”에 대한 소개는 다음 포스팅에 정리해보도록 하겠습니다.